Le formule relativistiche di trasformazione fra sistemi in moto relativo, basate sulla invarianza trasformazionale del continuo spazio temporale e della somma energia + massa, sono molto importanti, come ho avuto modo di mostrare in altri lavori [1],[2], per comprendere i meccanismi di autorganizzazione dei sistemi, partendo da quelli macroscopici in cui l’organizzazione viene inizialmente innescata.

E’ mia intenzione mostrare che vi è un certo risultato, che precede di gran lunga gli sviluppi della relatività, che è stato acquisito in modo alquanto ambiguo dalla scienza, ma che può inserirsi in modo estremamente interessante nel discorso sui fondamenti relativistici della teoria dell’organizzazione.

Si tratta della caratterizzazione ulteriore degli elementi invarianti, che hanno cioè una esistenza assoluta, del referente ultimo della realtà che sottende alla relatività dialettica.

I principi di conservazione del continuo spazio-tempo e della somma massa-energia non risolvono molti problemi per i quali occorre dare all’elemento assoluto una caratterizzazione maggiore di quella che risulta dalla semplice esistenza di “qualcosa” che può manifestarsi in modi alternativi. Intendo riferirmi al principio del “contenimento” del continuo nel discreto, introdotto in modo alquanto ambiguo nella formulazione Newtoniana ed in modo invece netto nella formulazione Leibniziana che ha portato alla costruzione della teoria monadistica.

Come Einstein ha riconosciuto in un articolo pubblicato su “Scientific American” nel 1950, gli aspetti fondamentali della teoria della relatività erano già presenti nel pensiero di Leibniz. Le due teorie, avendo un corpo comune, sono coerenti e ciò ci permette di affermare che la soluzione Leibniziana del problema del referente ultimo è aprioristicamente valida, in termini euristici, anche nell’ambito della teoria della relatività.

La parte fondamentale del ragionamento di Leibniz, poi proseguita nella costruzione di una teoria sulla costituzione della realtà che va sotto il nome di monadologia, pur essendo costituita da elementi puramente logici, non sperimentali, ha portato allo sviluppo di una matematica, l’analisi infinitesimale, senza la quale non sarebbero stati possibili gli sviluppi della scienza sperimentale moderna.

Il punto di partenza ha origine nel pensiero greco, nei paradossi zenoniani circa la collocazione del mondo nel tempo e nello spazio e circa la divisibilità della sostanza composta in sostanze semplici che investono, in sintesi la compatibilità del continuo e del discreto, il primo caratteristica necessaria dello spazio e del tempo, il secondo caratteristica necessaria degli oggetti.

La soluzione del problema da parte di Newton e di Leibniz consistette nell’introduzione del concetto di “limite”, da cui scaturirono i concetti di derivata e di integrale, secondo cui il discreto è il limite a cui tende il continuo. La validità sul piano euristico di tale concezione è fuori discussione; se una sommatoria si approssima sempre di più ad un determinato valore, vi è sempre una dimensione della sommatoria per la quale la differenza da tale valore, dal limite, è, a qualsiasi effetto pratico, trascurabile. Cionondimeno, la accettabilità sul piano euristico non implica la accettabilità sul piano logico. Se una sommatoria si approssima sempre di più ad un valore senza mai raggiungerlo, non è lecito assumerne l’equivalenza, e l’artificio analitico, di considerare una sommatoria infinita si rivela, nella sua pratica inattuabilità, per quello che è, cioè solo un artificio.

E’ particolarmente importante rilevare che l’insufficienza della soluzione di Newton e del primo Leibniz apparve evidente a quest’ultimo nelle condizioni in cui un limite non è definibile, cioè nei problemi che involvono l’infinito, come nella prima antinomia e come si prospettano oggi di fronte alla dimostrazione dell’esistenza di una espansione accelerata dell’universo. Di qui l’insoddisfazione di Leibniz che lo spinse ad andare oltre il punto raggiunto anche da Newton. L’idea di Leibniz fu quella di trasferire alla realtà la conciliazione logica implicita nel concetto di limite, così anticipando di quasi due secoli l’impostazione filosofica positivistica secondo cui, essendo l’intelletto partecipe della realtà, è assurda una sua dicotomizzazione da essa (nihil est in intellectu quod prior non fuerit in sensu).

Quindi, poiché nel concetto di limite è implicito un “contenimento”, una limitazione del continuo da parte del discreto, nella realtà deve considerarsi il continuo come “subordinato”, “compreso” nel discreto. Ne consegue che lo spazio e il tempo che inducono il concetto di continuità, in quanto per essi non è definibile una dimensione minima, non hanno una esistenza autonoma, come invece ha la monade, cioè l’elemento discreto che costituisce la realtà e che li contiene. Essi costituiscono un mezzo di inquadramento delle relazioni inframonadiche, un prodotto delle monadi.

Secondo Leibniz dunque l’assoluto è assunto nelle monadi, serie di elementi adimensionali, ossia giacenti fuori della struttura spazio-temporale in cui peraltro si manifestano. Si noti l’anticipazione, due secoli prima di Planck, della teoria dei quanti che possono farsi coincidere con le monadi semplici se si accetta l’idea, connessa alla monade, che i quanti possano manifestarsi nel continuo spazio temporale in modi alternativi, relativistici.

Tale conclusione può essere assunta nell’ambito della teoria della relatività perché è con essa coerente. D’altra parte bisogna bene intendersi su che cosa significhi la ricerca dell’assoluto nell’ambito di una teoria scientifica. Essa certamente non implica un affacciarsi alla metafisica, ma semplicemente stabilire. di fronte alla variabilità ed alla trasformabilità degli elementi della realtà, quali siano le leggi, cioè gli elementi costanti che ne governano l’organizzazione.

In questo senso, la monade è ancora un mezzo di rappresentazione necessario al ragionamento, ma il portato sostanziale della teoria leibniziana è costituito dall’affermazione della legge generale, quindi assoluta, del contenimento del continuo nel discreto. Questa legge costituisce un elemento strutturale fondamentale della costruzione della realtà ed è alla base dell’analisi infinitesimale. Anche l’approssimazione di Newton ne è, in fondo, un riconoscimento.

La matematica fa infatti a pieno titolo parte della teoria dell’organizzazione, sia pure nei limiti definiti dal teorema di incompletezza che la definisce come parte sintattica di un sistema che richiede un completamento semantico. Come Galileo aveva già detto (anticipando Gödel), la matematica rappresenta il “linguaggio” della natura. Il modo con cui il concetto della subordinazione del continuo al discreto si presta a risolvere il paradosso di Russell [3] è ancora una dimostrazione di come esso vada considerato come una legge fondamentale della matematica e quindi della realtà.

E’ chiaro che, se volessimo rappresentare un continuo spazio temporale costituente l’universo come limitato, senza che possa definirsi in alcun modo un “fuori”, ci troveremmo di fronte ad una realtà “matematica” per la quale mancherebbero le possibilità di rappresentazione. Cionondimeno, se noi decidessimo di trascurare la rappresentazione di un “fuori” potremmo rappresentare l’universo come una sfera. Ciò non impedisce la possibilità di fasi di espansione e contrazione, ma pur sempre nell’ambito di un volume limitato ed è allora chiaro che l’esistenza del limite comporta che i fenomeni di espansione ed accelerazione dell’espansione dell’universo vadano interpretati in maniera ben diversa da quella oggi in vigore, comportando la necessità di una curvatura delle traiettorie espansive indotta dall’esistenza del limite, condizione di curvatura che d’altra parte è un portato della relatività generale, nell’ambito della quale la condizione sferica dell’Universo era stata già ipotizzata da Einstein [4], [5].

La coincidenza del risultato mostra però, nella diversità delle linee di pensiero che lo hanno determinato, che è possibile immaginare, seguendo la linea di pensiero di Leibniz che sia la curvatura a determinare la gravità, mentre, seguendo la linea di pensiero di Einstein avvenga il contrario, cioè sia la gravità a determinare la curvatura. Ed è possibile immaginare che le due linee di pensiero siano equivalenti e possano trovare una sintesi.

Quando si osservano altre galassie, poste ai confini dell’universo osservabile, non può trascurarsi che la considerazione di un centro di gravità in cui sarebbe concentrata l’attrazione gravitazionale è ragionevole nei confronti di aggregati ma non di ammassi posti ad immense distanze l’uno dall’altro, nel qual caso la considerazione di un centro di gravità comune è priva di senso. Anche qualora lo si volesse individuare occorrerebbe considerare che gli enormi movimenti e trasformazioni di masse che si verificano nell’universo determinerebbero corrispondenti movimenti del centro di gravità.

E’ possibile, data la relatività del moto, che il nostro sistema sia in decelerazione nei confronti di un certo centro di gravità e veda quindi in accelerazione sistemi che in realtà sono in moto uniforme rispetto ad un altro sistema di riferimento; è possibile, data la forma sferica dell’universo che movimenti accelerati di certe galassie lontane siano dovuti all’attrazione esercitata da masse che esistono al di là del nostro orizzonte

Le due linee di pensiero, quella di Leibniz.e quella di Einstein, si sfiorano ancora, ma senza identificarsi come era avvenuto sul piano della curvatura delo spazio, in conseguenza di quello che fu l’errore più grande di Leibniz. Secondo Leibniz, se le relazioni inframonadiche si svolgono al di fuori dello spazio e del tempo che sono solo dei mezzi di rappresentazione, le relazioni spazio-temporali, ed in particolare le relazioni meccaniche, non possono avere un contenuto reale, ma solo apparente.

Ciò comporta la considerazione della monade come una entità chiusa, che può modificarsi solo in virtù di un principio interno. Sulla base di tale concezione, osservando un maglio che schiaccia un lingotto, dovremmo ritenere che il lingotto si schiaccia in virtù di un principio interno, non in virtù dell’azione esercitata dal maglio. Ciò è già di per sé difficilmente credibile; quando poi la conseguente e ovvia questione sul come accada che lo schiacciamento del lingotto si verifichi proprio in corrispondenza dell’avvicinamento del maglio, su come cioè si verifichi una armonia fra le modificazioni delle monadi, trova risposta, da parte di Leibniz, nell’intervento di Dio, diviene comprensibile un giudizio severo, assai critico, sulla costruzione leibniziana.

Invero a molti critici, quali il Russell, la costruzione di Leibniz è apparsa come l’opera di un folle. Certamente la soluzione finale, per uscire in qualche modo dal ginepraio in cui lo aveva condotto la sua speculazione filosofica, non appare all’altezza dei livelli speculativi raggiunti nell’impostazione della monadologia, ma ciò non ci può consentire di ridimensionare questi ultimi.

E’ però da osservare, a tal proposito, che la relatività generale giunge ad alcuni risultati che richiamano in modo straordinario anche queste ultime proposizioni di Leibniz. Come è noto infatti, secondo il principio einsteiniano di equivalenza, la modificazione interna equivale all’azione esterna e i due fenomeni sono indistinguibili. Gli effetti dell’azione gravitazionale di un corpo su di un altro sono equivalenti agli effetti di un movimento rotatorio o accelerato di quest’ultimo.

Einstein quindi introduce una equivalenza delle due azioni, non una esclusività dell’azione interna e dobbiamo quindi domandarci se è giustificata la chiusura estrema della monade alle azioni meccaniche ipotizzata da Leibniz, domanda alla quale possiamo rispondere che essa è giustificata solo per la monade elementare ultima (che può essere associata al quanto), ma non certo per le monadi ottenute per associazione delle monadi elementari che costituiscono la sostanza della vita dell’universo.

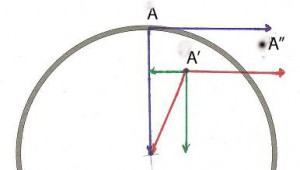

Secondo Leibniz, lo spazio e il tempo costituiscono una struttura di “rappresentazione” delle interazioni inframonadiche nella forma di interazioni meccaniche. Ciò comporta che vi siano almeno due monadi interagenti, senza le quali la monade ha solo potenzialità, è priva di rappresentazione spazio-temporale. L’interazione delle due monadi crea quindi uno spazio-tempo interno all’insieme costituito dalle due monadi, nell’ambito del quale le interazioni inframonadiche appaiono come interazioni meccaniche e quindi, seppure non possono modificare la monade ultima, possono determinare l’aggregazione o la scissione delle rappresentazioni delle due monadi elementari. L’associazione delle monadi avviene quindi nella rappresentazione spazio-temporale che è tutto quanto noi percepiamo e dove esse sono soggette alle interazioni meccaniche.

Ovviamente, vi sono anche interazioni fra le monadi che sfuggono alla rappresentazione spazio-temporale, prima di tutte proprio quella che dà luogo alla formazione della struttura spazio temporale stessa e che quindi ne è fuori, esprime cioè una condizione di “entanglement” fra le monadi interagenti che è (almeno sul piano della logica) prodroma al loro coordinamento spazio temporale.

Inoltre è possibile che anche le interazioni che trovano la loro rappresentazione nello spazio tempo inducano degli effetti sul modo come le monadi stesse si presentano nello spazio tempo, possano cioè determinare le trasformazioni massa-energia e vice versa all’interno della monade elementare. E’ possibile che l’apparire come energia o come massa, richieda che le interazioni inframonadiche raggiungano un certo livello critico al di sotto del quale la monade mantiene un grado di libertà che gli consente di oscillare fra le forme di apparenza, di mantenere cioè un livello di indeterminazione (onda-corpuscolo).

E’ chiaro, in definitiva, che se la limitazione della impenetrabilità delle monadi viene limitata alle sole monadi elementari, costituenti ultime della realtà, la dicotomia fra le due teorie scompare insieme alle paradossali conseguenze che l’errore leibniziano aveva determinato.

Ma vi sono anche delle concordanze fra altri aspetti della monadologia e le conseguenze, in termini di fondamenti della teoria dell’organizzazione, che abbiamo tratto dalla considerazione delle trasformazioni relativistiche che si verificano nei sistemi isolati macroscopici ad alta energia. Secondo Leibniz, in corrispondenza di determinate caratteristiche delle interazioni le monadi possono associarsi e fondersi (ovviamente sempre nell’ambito delle rappresentazioni spazio temporali) in una nuova unità, in cui le caratteristiche delle monadi componenti non sono più rintracciabili, mentre compaiono qualità nuove.

Si tratta dunque di un processo creativo che trova precisi riscontri nella teoria dell’organizzazione, ove prende il nome di “incollamento”. La nuova monade complessa sarà allora la componente elementare di una certa stratificazione di realtà nell’ambito della quale essa non può più avere le caratteristiche della chiusura alle interazioni meccaniche e quindi della indistruttibilità.

Dunque la monade complessa non deve essere chiusa alle interazioni meccaniche anche se essa rimane un “contenitore” che delimita uno spazio interno determinato dalle interazioni fra le monadi interne ed uno spazio esterno determinato dalle interazioni con le altre monadi complesse. Il limite è dunque un filtro selettivo, che esercita l’azione di contenimento su una certa qualità del contenuto. E’ un concetto che ritroviamo come elemento estremamente importante nella teoria dell’ organizzazione a tutti i livelli di organizzazione. Anche, ad esempio, nell’organizzazione sociale, all’interno della quale si determina una struttura interna dei valori, una semantica, che non trova riscontro nell’ambiente esterno.

Vi sono alcuni tipi di interazione che seguono integralmente il concetto leibniziano, nel senso che esse danno luogo a delle trasformazioni che si verificano internamente alle monadi elementari, quali le trasformazioni massa-energia e queste trasformazioni si svolgono secondo il principio di equivalenza di Einstein. Il fatto che le interazioni che danno luogo a queste trasformazioni si svolgano secondo la variazione seconda delle coordinate getta una luce sul ruolo che le infinità di punti di diverso ordine che compongono il continuo spazio-temporale possono giocare nella trasmissione di vari tipi di interazione.

In primo luogo, poiché, seguendo la teoria Leibniziana, le interazioni inframonadiche non si limitano a creare la struttura di base spazio-temporale, ma danno un contenuto alla monade che comprende l’alternativa massa – energia nelle varie forme in cui questa può apparire, è possibile che ogni forma di energia sia supportata da un substrato infinito di diverso ordine del continuo spazio temporale in cui vibra. (Si noti le somiglianze con la teoria delle stringhe). La curvatura delle traiettorie determinata dalla presenza del limite, che agisce su tutte le monadi complesse, potrebbe allora essere selettiva nei confronti delle varie forme di energia; potrebbe cioè esistere una variabilità dell’azione di curvatura nei confronti delle varie forme di energia.

Ciò potrebbe condurre ad una molteplicità di linee di contenimento e quindi all’intrecciarsi delle strutture sistemiche nella monade complessa che assomiglierebbe ad una struttura reticolare.

In secondo luogo, nell’ambito dello studio del processo organizzativo sono state individuate due fasi fondamentali, di sinergia e di sintesi dialettica. La sinergia ha diverse gradualità di manifestazione, dalla semplice aggregazione dei componenti del sistema, per la quale abbiamo determinato la necessità di un parallelismo motorio, all’incollamento profondo che porta alla formazione di una nuova unità operativa e che corrisponde, in termini leibniziani alla formazione di una monade complessa.

Non sono però ben individuate le condizioni per il verificarsi dell’incollamento, a parte l’intervento di altri campi di forza e l’individuazione di una messa in sintonia di certe linee di flusso dell’energia che però non dovrebbe operare su componenti costituiti esclusivamente di massa. Se però si accettasse l’idea, che scaturisce dalle impostazioni leibniziane, che sia la curvatura a determinare la massa, questa potrebbe essere rappresentarsi come l’avvitarsi dell’energia su se stessa, come in un vortice. Si potrebbe forse allora comprendere come il parallelismo motorio possa favorire la fusione di due vortici, mentre la divergenza, possa portare alla repulsione, all’assunzione, da parte dell’energia cinetica, di una direzionalità antigravitazionale. Il binomio attrazione – rifiuto, che nell’ambito del campo elettromagnetico ha due soli valori, si e no, avrebbe nel campo gravitazionale una polarità graduata, secondo l’angolo di incidenza delle linee di azione dei due componenti e della entità della energia cinetica convogliata. Questo argomento è sviluppato, al di fuori di ogni considerazione relativistica, in un altro lavoro [6].

Anche Dio muore.

Dunque, l’idea Leibniziana dell’intervento demiurgico, di una “armonia prestabilita”, non fa che esprimere il concetto che le interazioni fra le monadi, che ne determinano la rappresentazione non sono manifestazione di una attività completamente libera, ma sono manifestazione di leggi generali, di vincoli posti all’attività creatrice delle monadi e ciò è indiscutibile, costituisce la tesi fondamentale che dà legittimazione all’esistenza di una teoria dell’organizzazione. L’elemento demiurgico non fa che esprimere il concetto di una unitarietà cui deve farsi risalire l’universalità di tali leggi, gli dà un contenuto immanente per cui le monadi sarebbero le cellule del Dio.

Certamente, si tratta di una visione che non soddisfa alcuna esigenza religiosa, alcuna esigenza esistenziale, alcun bisogno d’amore e non ti promette la vita eterna. Ti dice invece che, se la tua complessità ti porterà ad una pienezza di forma, sarai uno, ma sarai solo. Perché la forma piena ha variabilità infinita. Sarai un anelito inestinguibile ad un amore impossibile perché la solitudine dell’uno è la stessa solitudine del tutto, la stessa infinita solitudine di Dio.

Dio può rompere la sua solitudine solo vivendo nella vita delle sue cellule e quindi variandone l’interazione di cui tu sei un esemplare. Si può però anche pensare che un grande insieme o anche la totalità delle interazioni vengano spezzate al raggiungimento di una forma piena, perché le monadi elementari, rese vuote di contenuti, ma piene di desiderio, abbiano nuove possibilità di incontrarsi e scontrarsi e così dal caos produrre nuove splendide stelle.

E dunque la vita dell’Uno, del contenuto è fuori del tempo che è invece la coordinata del vuoto, del desiderio. E dunque Dio è uno fuori del tempo, ma è infinito nel tempo in cui nasce, ama, odia, ride, piange e muore.

Note e Riferimenti.

[1] – Firrao S.: Lo sviluppo di processi oscillatori nei sistemi isolati ad alta energia, riportato in questo blog

[2] – Firrao S.: La formazione dell’ordine nei sistemi isolati macroscopici, in questo blog,

[3] – Il paradosso di Russell si riferisce alla teoria degli insiemi e consiste nella domanda: “la classe di tutte le classi che non appartengono a se stesse appartiene o non appartiene a se stessa?” Sia che si risponda che appartiene, sia che si risponda che non appartiene, si da luogo ad una contraddizione. Fra gli assiomi degli elementi di Euclide è compresa la proposizione secondo cui il contenuto non può contenere il contenente. Cantor ha però mostrato come ciò non possa affermarsi riferendosi agli infiniti, cosa che per la verità aveva già affermato Galilei, ma Cantor ne fece un elemento importante della sua teoria degli insiemi, utilizzata quindi da Frege nella ricerca dei fondamenti ultimi della matematica, ricerca messa in crisi dal paradosso di Russell. Il punto fondamentale trascurato è costituito dal fatto che la classe di tutte le classi è un elemento discreto, finito, anche se le classi sono in numero infinito e quindi per essa vale l’assioma di Euclide per cui il contenente contiene il contenuto e non può verificarsi il contrario. Quindi la classe di tutte le classi che non appartengono a se stesse può contenere queste ultime senza che possa porsi il problema della sua appartenenza o meno ad una delle classi contenute.

[4] – Einstein A.: Relatività, Torino, Boringhieri, 1967

[5] – Einstein A.: Il significato della relatività, Torino, Boringhieri, 1980

[6] – Firrao S.: La formazione di equilibri dinamici nei sistemi in disequilibrio, riportato in questo blog