Prof. Ing. Sisto Firrao, libero docente, Politecnico di Milano. Traduzione di un suo lavoro comparso su “International Journal of Science and Research”, marzo 2020

Sintesi.Lo stato di un quanto può essere modificato dalla presenza di altri quanti senza che possa sempre individuarsi una azione da questi proveniente. Ciò obbliga a ritenere che fra quanti adiacenti si svolga uno scambio di informazioni supportato da una sensorialità che crea una dipendenza reciproca. L’informazione può determinare nel quanto oggetto un “riconoscimento” che dà luogo ad una azione oppure può essere ritrasmessa ad altri elementi contigui, compito svolto dai quanti di spazio fino a raggiungere l’elemento riconoscitivo.. Richiamando elementi della teoria della relatività si mostra come il limite massimo di velocità costituito dalla velocità della luce è dovuto all’ azione frenante esercitata dallo spazio attraverso le azioni gravitazionale e elettromagnetica da esso mediate. L’informazione non sollecita alcuna azione frenante esercitata dallo spazio e può perciò viaggiare a velocità superiore a quella della luce.

1- Problema inerente l’essenza dello spazio. Sembra incredibile che nell’ambito di una discussione filosofica e scientifica che ha coinvolto i più grandi geni dell’umanità quali Aristotele, Cartesio, Newton, Leibnitz, Maxwell non solo non si sia compreso il ruolo centrale dello spazio nella generazione dell’essere ma lo si sia addirittura fatto coincidere con il suo opposto, con il nulla. E ciò fino al punto di prevedere qualcosa che lo riempia per giustificare l’azione a distanza quale il plenum di Aristotele e di Cartesio [1], l’etere di Maxwell.[2] o i campi di forza della fisica attuale. Solo Platone affermò che “la materia e lo spazio sono la medesima cosa”[3].

Il problema può essere posto nel senso di stabilire se lo spazio debba considerarsi una entità che fa parte della realtà fisica o se debba considerarsi come una entità non fisica la cui struttura non può quindi essere alterata dagli accadimenti del mondo fisico. Questa seconda soluzione ha dominato il pensiero umano fino ai tempi più recenti; per Newton lo spazio poteva essere considerato come un contenitore infinito la cui struttura non poteva essere alterata in alcun modo dagli avvenimenti fisici che si verificavano nel suo interno nonché dalla aggiunta o sottrazione di materia o energia, così che poteva affermarsi che lo spazio vuoto coincidesse con il nulla.[4] Anche coloro che ritenevano che lo spazio contenesse un “plenum” o un “etere” o”campi di forza”, non hanno avanzato l’ipotesi che lo spazio, semplicemente, fosse esso stesso una entità fisica, malgrado ciò dovrebbe sembrare ormai incontrovertibile dopo l’enunciazione della relatività generale cheha mostrato l’esistenza di una interazione gravitazionale fra la materia e lo spazio e la conseguente considerazione di quest’ultimo come una entità gravitazionale. Non vi è dubbio, infatti, che la gravitazione abbia la caratteristica della biunivicità, che cioè un corpo che subisce l’azione gravitazionale sia anche capace di esercitarla.

Se consideriamo questa soluzione, cioè l’ appartenenza dello spazio al mondo fisico, dell’essere, è chiaro che l’esistenza del nulla non può essere neanche ipotizzata perché non può esistere ciò che per definizione non esiste. L’ipotesi più ragionevole che possiamo fare è che l’essere sia infinito, sia pure costituito da parti che si distinguono in qualche modo, cioè l’ipotesi di un multiverso infinito.

2- Problema inerente la relazionalità dei quanti Il quadro concettuale sviluppato dalla fisica del secolo ventesimo con le teorie della relatività e dei quanti ci obbliga a dover considerare lo spazio ed i tempo come costituenti di unica entità e ci consente quindi di ritenere che questo spaziotempo abbia natura granulare, sia cioè composto di elementi infinitamente piccoli, i quanti, la cui composizione, come in un puzzle, determina lo spazio ed il tempo quali noi li percepiamo. Il quanto è una struttura relazionale, è cioè sempre in relazione coordinativa con l’esterno attraverso lo sviluppo di interazioni con esso senza che possa sempre individuarsi un’azione proveniente dall’esterno che dia origine a tale processo attraverso lo sviluppo di un meccanismo azione-reazione. Il problema sussisteva già nella fisica tradizionale antecedente agli sviluppi del XX° secolo nel verificarsi della interazione gravitazionale tra due corpi che richiede la necessaria preventiva avvertenza della reciproca presenza e ciò anche quando i corpi sono lontani ed il verificarsi della interazione richiede il superamento del nulla che, secondo Newton intercorre fra i corpi. Ad una specifica domanda in tal senso Newton infatti rispose di non sapere come ciò avvenisse anche se era certo che avveniva. E non vi è dubbio che lo studio delle interazioni fra i corpi abbia portato ad avanzamenti straordinari della conoscenza scientifica, ma è altrettanto vero che l’ignoranza dell’origine prima dell’azione che innesca il processo relazionale abbia privato la scienza di sviluppi di grande importanza.

Tornando al livello dei componenti ultimi dell’essere, rileviamo che il problema si era già posto per la monade di Leibnitz. Anche la monade è una entità indivisibile e chiusa che si modifica in termini di coordinamento con l’esterno autonomamente, non per effetto di una azione meccanica esterna nei cui confronti è impenetrabile. Il problema, come è noto, non fu risolto da Leibnitz, (giacché non può dirsi soluzione il richiamo ad una azione demiurgica) ma il quadro complessivo dell’essere che ci prospetta la fisica del secolo ventesimo ha in se tutti gli elementi per risolvere il problema. Essa ci ha mostrato che il moto, da cui origina il concetto di tempo è parte, come quarta dimensione, del componente elementare dell’essere. Ciò significa che il problema dell’adduzione del cambiamento dall’esterno del quanto non esiste perché il motore del cambiamento è già interno al quanto. Ci ha inoltre mostrato che l’esistenza di una capacità di sentire l’altro costituisce una condizione necessaria e ineludibile perché si verifichi la relazionalità che si manifesta nella interazione che è all’origine del divenire. Ne consegue altrettanto necessariamente che la indivisibilità del quanto non può negare la esistenza di componenti più piccoli tenuti insieme da legami che, pur essendo di enorme forza, non impediscano scambi minimi o stati di eccitazione superficiali necessari per sentire gli altri con cui relazionarsi, per avere cioè la sensibilità.

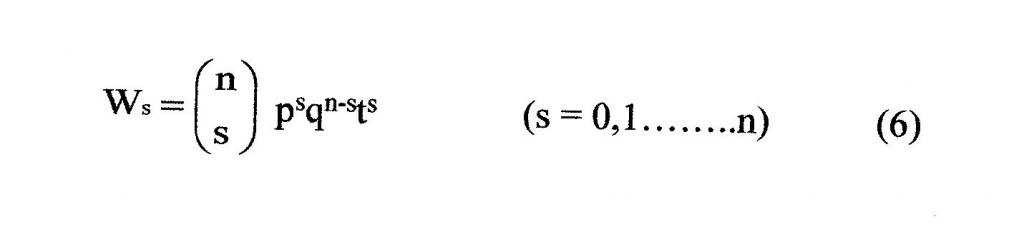

Naturalmente il quanto non deve semplicemente “sentire” l’altro e produrre una azione. Ciò infatti non darebbe luogo ad alcun processo organizzativo ma al raggiungimento della massima entropia, come ormai sappiamo dal problema similare, governato dalla seconda legge della termodinamica, relativo ad un insieme di molecole che interagiscono, in volume limitato, attraverso il solo passaggio di calore. Il sensorio deve essere costituito da un certo numero di elementi sensori che, attraverso la variazione posizionale o la eccitazione differenziata, possano trasmettere una informazione costituita da un certo numero di bit afferenti all’appartenenza ad una delle forze fondamentali e, nell’ambito di questa, alla caratterizzazione di attrazione o rifiuto della risposta.

Dunque, nello schema che scaturisce dalla combinazione teoria della relatività – teoria quantistica, in cui il nulla non esiste, è giocoforza pensare ad una sensibilità di contatto fra gli elementi adiacenti dello spazio che funzionano da mediatori. L’informazione sensoria può essere ritrasmessa ad altri elementi contigui fino a raggiungere un elemento dotato di una struttura di riconoscimento in cui si dà luogo alla azione (che può essere di attrazione o rifiuto, in una delle quattro forze fondamentali) ossia con cui si instaura una dipendenza motoria, realizzando così l’azione a distanza.

Se il quanto non esiste da solo, se ha bisogno dell’altro per esistere, significa che esiste in quanto parte del tutto. Dunque il relazionismo che si manifesta attraverso il link costituito dall’informazione sensoria e che attraverso il riconoscimento può divenire un forte legame associativo è il collante che restituisce all’universo la caratteristica di unità indivisibile che gli era stata sottratta dalla teoria dei quanti. Pur legando le particelle ne rende possibile il mutamento della posizione reciproca (come abbiamo constatato attraverso il fenomeno dello “entanglement” anche a grande distanza) e del legame di dipendenza.

Dovremo dunque considerare la sensibilità all’altro, come un costituente dell’elemento ultimo, accanto allo spazio e al tempo e questa conclusione coincide con quella della teoria detta del “panpsichismo” giacché la sensibilità è la fonte della attività psichica. Questa teoria si è sviluppata nell’ambito degli studi psicologici, quindi in un ambito ben lontano da quello della meccanica quantistica, per le difficoltà altrimenti insormontabili di spiegare la nascita dei meccanismi psichici partendo dalla materia inanimata, in particolare della coscienza, che non sembra potersi ridurre ad un meccanismo robotico governato dalle leggi della fisica classica. Anche la variazione della dipendenza ha il suo equivalente psichico nel “transfert”.

Naturalmente noi dovremo ritenere che lo sviluppo del sistema complesso sia sempre accompagnato da uno sviluppo del sensorio, della informazione, della sua struttura stratificata secondo livelli di rigidità e della possibilità di modulazione della parte più flessibile, condizioni che determinano l’insorgere di nuove funzionalità non rilevabili a livello quantistico. Fa comunque specie rilevare come il pensiero sia costituito, come già intuito da Aristotele [5] dalla modulazione del sensorio nella sua parte più flessibile [6], nonché l’esistenza a tutti i livelli di complessità di un sensorio rigido, immodificabile che trasmette comandi incoercibili che possono essere leggi della natura o memorie acquisite nel corso dell’evoluzione del sistema.

3 –Sulla interazione gravitazionale elementare. Il contributo più importante dato da Newton alla fisica, da cui sono derivati in cascata risultati fondamentali della meccanica, può farsi giacere nella seguente proposizione: “In ogni fenomeno fisico variazionale, cioè non inerziale, le variazioni del fenomeno si realizzano in corrispondenza di variazioni delle coordinate infinitesime del primo ordine (derivata prima). In corrispondenza di variazioni delle coordinate infinitesime del secondo ordine (derivata seconda) le variazioni del fenomeno sono del tutto trascurabili.

Il contributo più importante dato da Einstein può invece farsi giacere nella seguente proposizione: “In ogni fenomeno fisico variazionale, cioè non inerziale, sussistono non solo variazioni che si realizzano in corrispondenza di variazioni delle coordinate infinitesime del primo ordine (derivate prime) ma anche variazioni che si realizzano in corrispondenza di variazioni delle stesse coordinate infinitesime del secondo ordine (derivate seconde). I due tipi di variazione sono di segno opposto e si verificano sugli stessi elementi oggettuali.[7].

Noto, per inciso, che per Newton, inventore (in concorrenza con Leibnitz) del calcolo infinitesimale, non poteva sfuggire la considerazione che l’integrale delle variazioni seconde avrebbe potuto avere una grande importanza se il campo di integrazione fosse stato abbastanza grande. La constatazione che anche a livello di campi assai estesi, quali ad esempio il sistema solare, la determinazione dei valori delle variabili fisiche non mostrava alcun segno di una contribuzione delle variazioni seconde, lo portò alla considerazione non solo della trascurabilità, ma addirittura della loro nullità. Einstein invece ha mostrato che la variazione seconda non è mai nulla, ma è talmente piccola da non essere rilevabile se non si assumono intervalli di integrazione assai più ampi di quelli considerati da Newton, ad esempio, per quanto riguarda le variabili astronomiche, dimensioni galattiche o dell’intero universo. .

Ciò premesso riesaminiamo l’analisi, fatta da Newton, del moto di due masse m1 e m2 soggette esclusivamente alla reciproca attrazione gravitazionale apportandovi le variazioni imposte dalla teoria della relatività [8]. Le ipotesi che sono alla base dello studio di Newton sono: corpi assolutamente rigidi, sistema isolato, nessuna interazione con l’osservatore. Consideriamo in particolare il moto di allontanamento che fa seguito allo scontro. Questo moto è caratterizzato in ogni istante dai valori della velocità relativa delle due masse e quindi dall’energia cinetica E, della forza di attrazione gravitazionale F e dalla distanza fra le due masse s. Nella trattazione di Newton si assume che un gradiente dell’energia cinetica determini una forza capace di controbilanciare la forza gravitazionale. Newton cioè scrisse la famosa relazione.

dE/ds =– F (1)

che implica lo sviluppo di una variazione di energia cinetica eguagliante la forza gravitazionale in corrispondenza di ogni valore della distanza. La funzione dell’energia cinetica è ottenuta, nella trattazione di Newton, integrando la (1) ovviamente sostituendo alla F la sua esplicitazione in termini di masse e loro distanza e così ottenendo:

E= -km1m2 /s + C (2)

dove k è la costante di gravitazione e C il valore iniziale di E.

Quindi, secondo la trattazione classica, se l’energia cinetica ha un valore iniziale sufficientemente alto (valore di fuga) vi è nel processo di allontanamento che segue lo scontro un punto a partire dal quale l’ attrazione gravitazionale decresce più rapidamente dell’ energia cinetica cosicché il moto di allontanamento diviene irreversibile.

Secondo la teoria della relatività invece, durante il processo di allontanamento si verifica una trasformazione di energia cinetica in massa che implica un aumento dell’attrazione gravitazionale, in quantità equivalenti, trasformazione che termina solo con l’esaurimento dell’energia cinetica cosicché è sempre raggiunto un punto di inversione del moto da allontanamento ad avvicinamento, quale che sia il valore iniziale dell’energia cinetica.

Einstein ha spiegato il motivo perché queste trasformazioni siano sfuggite nell’ambito della meccanica classica: “Un confronto diretto con l’esperimento non è possibile al giorno d’oggi perché i mutamenti dell’energia E a cui possiamo sottoporre un sistema non sono grandi abbastanza da rendersi percettibili come mutamento della massa inerziale del sistema. E/c2 risulta troppo piccola in confronto alla massa m che era presente prima dell’alterazione energetica “ [9]

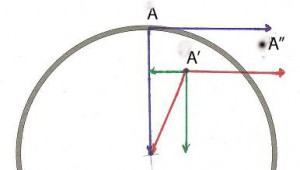

In fase di allontanamento si verifica dunque un processo di condensazione del quanto di energia dalla dimensione infinitesima del primo ordine alla dimensione infinitesima del secondo ordine del quanto di massa, mentre avviene l’opposto in fase di avvicinamento, si ha cioè l’espansione del quanto di massa infinitesimo del secondo ordine in quanto di energia infinitesimo del primo ordine. Il fenomeno fisico appare così un processo trasformazionale oscillatorio.

É importante rilevare, ai fini dello sviluppo del nostro lavoro, come si modifichi l’ampiezza, in termini di tempo, della oscillazione fra il punto iniziale del moto di allontanamento ed il punto finale di annullamento dell’energia cinetica, al variare dei valori iniziali della velocità e della attrazione gravitazionale.

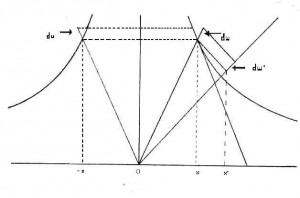

Per quanto riguarda l’attrazione gravitazionale iniziale è ovvia la crescita con essa del suo potere frenante il moto di allontanamento e quindi l’effetto di decremento della dimensione dell’oscillazione. Per quanto riguarda l’effetto della velocità iniziale occorre considerare, in linea con la teoria quantistica, le forze gravitazionali come costituite da un insieme di quanti di forza, ciascuno agente su un quanto di spaziotempo caratterizzato da un certo quantitativo di spazio per unità di tempo. La realizzazione di una maggiore velocità implica quindi la presenza di una maggiore quantità di spazio nello stesso istante (principio di sovrapposizione degli stati) e quindi una molteplicità di forze gravitazionali elementari agenti nello stesso istante. In altre parole ciò equivale ad affermare che le unità di spazio sollecitano le forze gravitazionali e quindi la loro sovrapposizione nella velocità comporta una maggiore sollecitazione gravitazionale complessiva. In definitiva la dimensione dell’oscillazione decresce al crescere dei valori iniziali sia della gravitazione che della velocità, come d’altra parte già affermato da Einstein e Infeld [10].

Vi è dunque un valore limite della velocità iniziale in corrispondenza del quale la dimensione della oscillazione si annulla.tutta l’energia è istantaneamente trasformata in massa. Naturalmente questo limite è variabile a seconda della dimensione della forza gravitazionale iniziale. Vi è anche un limite della attrazione gravitazionale iniziale in cui l’ampiezza della oscillazione si annulla, quale che sia la velocità, cioè non può sussistere alcun moto di allontanamento per la sua immediata trasformazione in massa (buchi neri)

Alla luce del risultato secondo cui vi è interazione fra la materia e lo spazio, possiamo ritenere che i risultati raggiunti possano essere estesi anche alla condizione in cui il corpo in movimento non sia sotto l’azione di un altro corpo come nel caso esaminato della interazione gravitazionale fra due corpi, ma sia in movimento libero nello spazio. In tal caso dovremo ritenere che la prima legge della dinamica, nella formulazione di Galileo e di Newton, non sia completamente corretta in quanto non considera l’azione frenante gravitazionale esercitata dallo spazio, sia pure per infinitesimi di ordine superiore al primo, quindi per distanze enormemente grandi.

4 – Problema inerente la velocità della luce Dunque non esiste un solo valore limite della velocità dei corpi gravitazionali, nel senso che vi sono tanti valori limite quanti sono i valori della forza gravitazionale. Nel caso del moto inerziale in cui l’elemento frenante, cioé la forza gravitazionale esercitata dello spazio, ha un valore costante si ha ovviamente un solo valore della velocità limite.per ogni valore della massa del corpo..

Una condizione simile deve sussistere nel caso della luce in cui l’azione frenante è costante. Consideriamo il secondo principio della dinamica “F=ma” dove F è una forza. m è la massa ed a è l’accelerazione, cioè la derivata della velocità. Se, mantenendo costante la forza riduciamo la massa aumenta l’accelerazione; possiamo cioè dire che, al tendere a zero della massa l’accelerazione tende all’ infinito. Visto che la luce non ha massa, alla più piccola sollecitazione la particella dovrebbe subire una enorme accelerazione e raggiungere una velocità infinita. Tale applicazione della seconda legge ha però il difetto di non considerare la variazione seconda che contiene l’elemento frenante costante e che porta la velocità limite a c. Naturalmente, quando la massa si avvicina allo zero, la velocità limite si avvicina alla velocità della luce cosicché possiamo dire che la velocità della luce è una velocità limite per tutte le particelle che subiscano una resistenza da parte dello spazio anche se solo elementi di massa piccolissima possono raggiungere velocità che si avvicinino a quella della luce.

5 – La velocità dell’informazione. Nell’ambito gravitazionale o elettromagnetico abbiamo sempre una particella che si allontana ed un altra che si oppone all’allontanamento secondo diverse metriche spaziotemporali. Ciò non avviene nel caso della informazione ove non vi è nessuna particella che si muove ma solo un messaggio che si trasmette attraverso il contatto superficiale senza sollevare alcuna resistenza e a velocità che in teoria potrebbe essere infinita. É l’unico caso in cui non vale la legge relativistica secondo cui in ogni fenomeno fisico occorre considerare le variazioni infinitesime del primo e del secondo ordine in quanto in questo caso non esistono le due cause variazionali contrapposte che possano dare luogo al processo dialettico. Il processo si svolge integralmente nell’ambito delle particelle più piccole esistenti nei cui confronti non esiste un infinitesimo di ordine superiore.

La sensibilità all’altro introdotta in questo studio costituisce un legame comunicativo immateriale fra i quanti che forma una rete che racchiude in un immenso sistema comunicativo l’intero universo ed entro la quale la comunicazione può viaggiare ad una velocità superiore a quella della luce. Essa è costituita da una modificazione della disposizione di certi componenti, ossia della forma a mezzo di scambi minimali di energia a livello locale, a somma nulla, Essa cancella la relatività della simultaneità e consente quindi la determinazione di un tempo assoluto.

Riferimenti. . [1] – Descartes: Principia Philosophiae, ed. J.Vrin 1964

[2] – Maxwell: Campo ed etere, 1890 Universale scientifica Boringhieri, Torino 1967

[3]-Platone: Timeo (sez. 2, 209 b)

[4]-Newton: Principi matematici della filosofia naturale. Scolio iniziale. A cura di A. Pala UTET Torino 1965

[5]-Aristotele: Dell’Anima, 3,427a, 427b, 428b, Laterza, Bari, 1973

[6]-Firrao Sisto: Il processo di associazione stimolo-risposta nelle reti stratificate. V meeting ,sulla neuroriabilitazione, Clinica Neurologica della II Facoltà di Medicina, Napoli, 6-7 ottobre 1989

[7]-Einstein: Sulla teoria generalizzata della gravitazione, in Le Scienze.1968-2018, pag.68, traduzione di un lavoro comparso su “Scientific American” Aprile 1950.

[8]-Firrao Sisto: Lo sviluppo di processi oscillatori nei sistemi isolati ad alta energia. In Studi sui sistemi complessi, Cap. 4 ed. Lulu 2011, nonché in Cybernetica, XXXI, 4,1988

[9]-Einstein A. Uber die Spezielle und Allgemeine Relativitatstheorie, Lipsia 1916

[10] – Einstein A., Infeld Leopold: The evolution of Physics, 1938 . Pag 204 della traduzione italiana, Boringhieri, Torino 1965